Computer waren Rechensklaven. Man sagte ihnen, was man getan haben möchte, und drückte man sich klar genug aus, erhielt man das gewünschte Ergebnis. War der gegebene Befehl ungenau, missverständlich oder mehrdeutig, stimmte das Ergebnis nicht mit den Erwartungen überein – oder die Befehlsausführung wurde verweigert; auf dem C 64 hieß das „Syntax Error“. Wer einen Computer bedienen wollte, befolgte einen Ablauf, der wenig intuitiv ist.

Der Beitrag bildet das vierte Kapitel im Buch „Der Apple-Faktor“. (bei amazon.defür 14,90 Euro bestellen)

- Finde heraus, ob der Computer das Gewünschte überhaupt erledigen kann – Blick ins Handbuch.

- Finde heraus, welche Angaben der Computer dazu benötigt – Blick ins Handbuch.

- Formuliere dein Anliegen so, dass der Computer dich versteht – Blick ins Handbuch.

- Gib deine Anweisungen über die Tastatur ein.

- Prüfe, ob das Ergebnis sinnvoll ist. Wenn nicht, dann

- Beginne von vorn.

Statt immer im Handbuch zu blättern, haben sich Computeranwender wichtige Befehle gemerkt. Aus dieser Zeit stammt noch das Credo der Ingenieure: Das erklären wir in der Anleitung; in der Kurzform „RTFM“ (Read the fucking Manual). Bei jedem Computer und Programmpaket wurde umfangreiche Lektüre mitgeliefert, deren Qualität und Nutzbarkeit starken Schwankungen unterlag.

Computer wurden von Mathematikern theoretisch definiert, von Ingenieuren gebaut und von Managern gekauft. Diese drei Menschentypen haben grundverschiedene Ansichten davon, was effektiv, sinnvoll, verständlich, nachvollziehbar, leicht bedienbar ist. Den normalen Nutzer fragt meist keiner. Wer einen Computer bedienen wollte, musste also denken wie ein Ingenieur: Befehl + Objekt + Parameter. Dass diese Art der Computerbedienung sehr wirkmächtig ist, bleibt unbestritten. Oft ist sie schneller als das Klicken mit der Maus – sofern man den benötigten Befehl im Kopf hat und flott tippen kann. Aber sie ist alles andere als intuitiv.

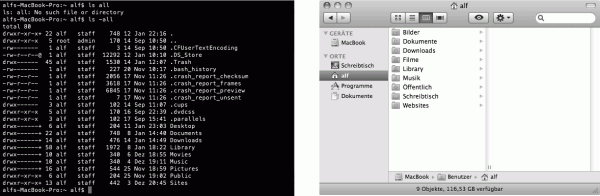

Anzeige eines Ordnerinhalts via Kommandozeile und im Finder. In der ersten Zeile habe ich mich vertippt (dort fehlt das „-“ vor dem Parameter). Die erhaltenen Informationen sind aufschlussreich: Zu jedem Eintrag werden die Rechte (wer etwas lesen/schreiben/ausführen darf) aufgeführt. Wirkmächtg, aber nicht intuitiv. Das Terminal wartet auf eine neue Eingabe. Der Mac-Finder blendet Dateien aus, deren Name mit . beginnt. Ein Automatismus in der GUI lässt nicht die englischen Bezeichnungen, sondern deren deutsche Entsprechungen als Namen erscheinen. Es gibt weniger Informationen, dafür lädt die Darstellung dazu ein, zur Maus zu greifen und etwas zu tun: einen Ordner in einen anderen legen, eine Datei in einen Ordner legen oder einen Ordner umbenennen. Dazu brauche ich keine Computerbefehle zu lernen, sondern tue es einfach. Die Symbole am oberen Fensterrand rufen bestimmte Funktionen auf oder lassen den Ordnerinhalt anders anzeigen – ein Klick genügt. [Screenshots]

Nachdem Doug Engelbart demonstriert hatte, wie mit einer Maus der Bildschirminhalt beeinflusst und manipuliert werden kann, war der Weg vorgezeichnet: Die Linearität der Befehlszeile weicht den zwei Dimensionen des virtuellen Schreibtisches.

Fläche statt Zeile

Bei Befehlszeilen sind die Befehle und ihre Ergebnisse linear untereinander sichtbar, allenfalls lässt sich zurückscrollen, um alte Ein- oder Ausgaben erneut einzusehen. Es gibt jedoch nur eine Stelle, an der Befehle entgegengenommen werden: dort, wo der Cursor blinkt, in der untersten Zeile. Auf dem virtuellen Schreibtisch werden Befehle nicht mehr linear an einer vorgegebenen Position eingegeben, sondern ich kann den Mauszeiger frei bewegen, um Icons oder Befehle anzuklicken. Es entspricht der räumlichen Orientierung, zunächst nicht die Aktion zu bestimmen, sondern zuerst das Objekt zu lokalisieren und erst im Anschluss den Befehl anzugeben. Denn die Möglichkeiten zur Befehlsangabe (Schaltflächen oder Menüs) befinden sich an fester, erkennbarer Stelle, was bei den Objekten nicht sicher ist, diese müssen oft erst einmal gefunden werden.

Will man Dateien kopieren, muss man diese erst einmal finden. Auf der Kommandozeile würde der Befehl lauten: copy ursprungsangabe/dateiname zielangabe/dateiname. Um den Befehl eingeben zu können, muss man bereits wissen, was wo ist – wieder eine Aufgabe für den Nutzerkopf. In der GUI dagegen öffne ich einfach ein ↑ Fenster und suche meine Datei. Habe ich sie gefunden, kann ich sie direkt anfassen und an den Zielort bewegen. Der Zielort kann der Desktop oder ein Datenträger-Icon oder auch ein Programm- oder Dokumentfenster sein. Soll die Datei an einen anderen Ort, habe ich mir vorher meist ein zweites Fenster geöffnet, in dem ich den Zielort eingestellt habe. Statt das Datei-Icon zu bewegen, kann ich den Befehl „Kopieren“ auswählen und am Zielort „Einfügen“ anklicken; das direkte Bewegen ist aber schneller.

Mit dem Bewegen von einem Fenster in ein anderes kann ich beispielsweise Bilddateien in Dokumente einfügen: die Bilddatei aus dem Ordner- oder eMail-Fenster an die richtige Stell im Dokumentfenster bewegen. Das Überwinden der Fenstergrenzen funktioniert intern über die gleichen Funktionen, die auch die Zwischenablage möglich machen. Beim Mac kann ich fast alles überallhin bewegen, im „schlimmsten“ Fall wird nur der Dateipfad, Dateiname oder das Datei-Icon eingebunden. Unter Windows ergibt das Bewegen eines Elements aus einem Fenster in ein anderes seltener das gewünschte Ergebnis, wenn überhaupt eines.

Befinden sich Ursprungs- und Zielort beim Datei-Bewegen auf dem selben Datenträger, wird die Datei verschoben. Befinden sie sich auf unterschiedlichen Datenträgern, wird automatisch eine Kopie angelegt. Auf der Kommandozeile entscheidet der Nutzer, ob eine Datei kopiert oder bewegt (copy/move) werden soll. Die GUI tut entweder das eine oder andere – obwohl ich die selbe Aktion ausführe. Über Menübefehle wäre der Unterschied nachzubilden: zum Kopieren wähle ich „Kopieren“ im Bearbeiten-Menü, zum Verschieben „Ausschneiden“ – dann sollte ich aber das „Einfügen“ am Zielort nicht vergessen.Manche Icon-Aktionen lassen sich durch Tasten beeinflussen. Zieht man ein Datei- auf ein Ordner-Icon, wird die Datei in den Ordner verschoben. Drückt man dabei [Alt], ist der Befehl auf „Kopie anlegen“ geändert: Die Datei bleibt an ihrem Ort, und eine Kopie landet im Ordner. In der gleichen Logik wird ein markierter Bereich innerhalb eines Dokumentfensters an die neue Stelle verschoben, bewege ich ihn aus dem Fenster, wird am Zielort eine Kopie angelegt, er bleibt im Ursprungsfenster erhalten.

Damit der virtuelle Schreibtisch sich auf den realen Schreibtischen verbreiten konnte, müssen technische und soziale Voraussetzungen erfüllt sein. Die direkte Befehlseingabe benötigt kaum Rechnerressourcen, erst die Befehlsausführung verbraucht diese. Eine grafische Benutzeroberfläche benötigt Rechenzeit und Platz im Arbeitsspeicher, auch wenn der Nutzer gar nichts tut. Allein das Bewegen des Mauszeigers, wobei die reine Bewegung ja keinen Befehl ausführt, verbraucht Rechnerressourcen. Also mussten die Computer leistungsfähiger werden, damit genügend Ressourcen für Bildschirmdarstellung, Nutzerinteraktion und Befehlsausführung zur Verfügung stehen. Dank Moore’s Law geschah dies bald.

Die Verbreitung der Computer ist eng mit der gesellschaftlichen Einschätzung der Computernutzung verbunden: Sieht man Computer als etwas an, das spezielle Fähigkeiten erfordert, oder sollte grundsätzlich jeder einen Computer bedienen können? Erst wenn die Gesellschaft möchte, dass jede und jeder einen Computer bedienen kann, entsteht das Bedürfnis, Computer ohne Handbuch bedienen zu können. Beim Autofahren schauen wir auch nicht in die Bedienungsanleitung. Wie beim Auto, das Anfang des 20. Jahrhunderts noch fast ausschließlich von Chauffeuren bedient wurde – bevor es selbstverständlich war, selbst zu fahren –, verstärkte die zunehmende Verfügbarkeit die gesellschaftliche Forderung nach Nutzungskompetenz. Ein sich selbst verstärkender Kreislauf aus immer mehr Fahrzeugen, besseren Straßennetzen, schneller Zielort\-erreichung, Unabhängigkeitsgefühl und günstigen Preisen ließ die Auto- und davon abhängige Industrien zu einem der wichtigsten Wirtschaftsbereiche des 20. Jahrhunderts werden.

Um das gesellschaftliche Interesse zu wecken, benötigte der Computer Anwendungsbereiche, deren Nützlichkeit allgemein anerkannt ist. Bei Textverarbeitung und Tabellenkalkulation entdeckten beispielsweise Manager schnell den Nutzen und konnten auf Sekretärinnen verzichten,Zur Frage, ob Computerspiele nun verteufelt oder gefördert gehören, verweise ich auf Steven Johnsons differenzierte Analyse „Neue Intelligenz. Warum wir durch Computerspiele und TV klüger werden“. indem sie ihre Schreiben selbst aufsetzten und Kalkulationen selbst durchführten. Im Heimbereich verführen Computerspiele Kinder und Jugendliche zur PC-Nutzung.

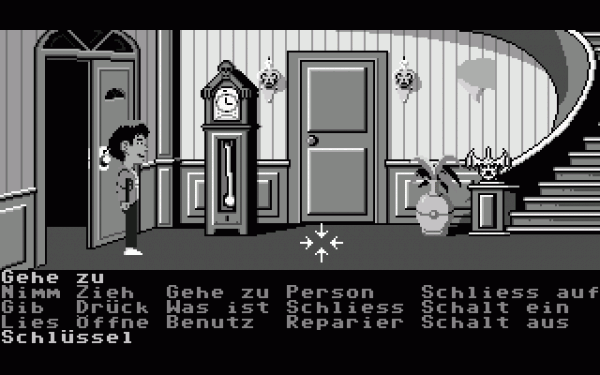

Zum Starten eines Spiels braucht es nur wenige Befehle: Verzeichnis des Datenträgers anzeigen, damit man den Programmnamen erfährt, ggf. Programm laden und Programm starten. Grafisch orientierte Spiele verfügen über eine eigene GUI, auch wenn dies im ersten Moment nicht immer klar erkennbar ist. Die Bilder auf dem Bildschirm wollen mittels tastatur-, joystick- oder mausgesteuerter Spielfigur erkundet werden. Bestimmte Aktionen lassen sich ausführen, andere nicht. Zum Spielgenuss trägt bei, die Logik der Bedienung zu durchschauen und korrekt anzuwenden.

Eines der Spiele, die ihre Steuerung offenlegten, war „Maniac Mansion“ (1986). Das SCUMM-System basiert darauf, dass man einen Befehl anklickt und danach das passende Objekt im Bild, beispielsweise „Öffne Tür“. Daraufhin führt die Figur dies aus. [Abbildung: Tentakelvilla.de]

Die erste durchkonzipierte und alltagstaugliche GUI entwickelten die Forscher 1973 im drei Jahre zuvor gegründeten PARC mit ihren „Alto“-Computern. Doch erkannte das Xerox-Management nicht, welches Potenzial dort entstand. Bei Vorführungen und Debatten mussten die motivierten Forscher die Bedeutung ihrer Entwicklungen stets neu darlegen; viele verließen das Forschungszentrum frustriert und gründeten eigene Unternehmen.

Währenddessen arbeitete Apple an einem Nachfolger zu seinem Apple-][-Computer. Jef Raskin, der die PARC-Forschungen kannte, brachte Apple-Chef Steve Jobs dazu, sich die Computer vorführen zu lassen. Xerox gewährte mehreren Apple-Ingenieuren Einblick in die PARC-Forschungslabor, wo ihnen die Augen übergingen. Jobs erkannte das Potenzial und löcherte mit seinen Mitarbeitern die Wissenschaftler. Nach diesem Besuch 1979 dauerte es bis 1984, als Apple den Lisa-Computer vorstellte. Darin waren viele Grundlagen aus dem Alto übernommen und weiterentwickelt. Doch Lisa war ein Flop: Zu teuer, zu leistungsschwach, und es gab kaum Software. Beim Macintosh, der ebenfalls 1984 quasi als günstiges Konkurrenzprodukt zur Lisa erschien, sollte das anders sein.

Jef Raskin benannte das Computerprojekt nach seiner Lieblingsapfelsorte. Optisch glich der Macintosh-Bildschirm dem der Lisa, doch es gab viele Verbesserungen. Der Macintosh war in jeder Hinsicht schlanker als Lisa. Umso größer waren die Herausforderungen für die Programmierer. Mit seinem „The Book of Macintosh“ schuf Raskin die theoretischen Grundlagen für den Computer, zog sich aber nach einem Streit mit Steve Jobs aus dem Projekt zurück. Seine konzeptionellen Grundlagen wurden beibehalten.

Ein wichtiges Vermächtnis von Raskin sind die heute noch geltenden Regeln zum Interface Design. Das bedeutet beispielsweise strikte Konsistenz: Hat ein Element ein bestimmtes Verhalten und eine bestimmte Funktionalität, so muss ein ähnliches Element ein ähnliches Verhalten und eine ähnliche Funktionalität aufweisen. Das bewirkte ein Umdenken: Jede Idee ist zunächst theoretisch zu durchdenken und konzeptionell in das bestehende System zu integrieren, bevor eine Codezeile getippt wird.Eine anekdotische Ausnahme bildet der Mac-Taschenrechner. Steve Jobs war mit dem Aussehen unzufrieden, und so schuf der Programmierer die Möglichkeit, das Aussehen des Rechners per Mausklick zu verändern – so lange, bis eine Kombination gefunden wurde, die Jobs absegnete. Statt „Welche Funktion können wir einbauen“ oder „Welcher Befehl fehlt noch“ war die entscheidende Frage: „Wie können wir eine Funktionalität umsetzen“. Ein Leitfaden definierte für alle, wie Programme auszusehen und sich zu verhalten hatten.Auch andere Software-Firmen hielten sich daran, sodass erstmals eine einheitliche Nutzung quer durch alle Programme entstand. Somit mussten Nutzer nicht jedes Programm neu lernen, sondern konnten sich auf die programmspezifischen Leistungen konzentrieren.

Einmal statt dutzendfach

Auf der Kommandozeile gab es Dutzende Möglichkeiten, beispielsweise eine bearbeitete Datei zu speichern. Jedes Programm brachte seine eigene Variante mit, da der Entwicklungsaufwand jeweils gering war. In Ermangelung einer universalen Bedienweise wurde die Bedienlogik jeweils dem Programm angepasst. Daher musste für jedes Programm separat gelernt werden, wie die Speicherfunktion aufzurufen und zu bedienen ist. Auch wenn sich manche Varianten ähnelten, konnten sie fundamental verschieden funktionieren. Das beginnt mit der unterschiedlichen Bezeichnung des nötigen Befehls, geht über unterschiedliche Tastenkürzel bis hin zu Pseudo-Menüs (wo auf einem Bildschirm mögliche Befehle aufgelistet werden) und deren Erreichbarkeit, Anordnung oder Bedienung. In manchen Fällen musste umständlich durch die Datenstruktur navigiert werden, oder man musste den Dateipfad aus dem Kopf eingeben, mitunter waren spezielle Parameter nötig.

Jeder Programmwechsel war mit einer neuen Bildschirmdarstellung verbunden. Für ein anderes Programm musste das alte komplett verschwinden. In einer GUI dagegen bildet der Bildschirm eine Arbeitsfläche, auf der die Programme erschienen. Hinter den Fenstern ist immer derselbe Hintergrund sichtbar. Statt durch einen Programmstart selbst in eine andere (Bildschirm-)Umgebung zu wechseln, erscheinen die Programme auf der bekannten Arbeitsfläche. Genauso wie zusätzliche Geräte auf meinem realen Schreibtisch meine Arbeitsmöglichkeiten erweitern und ich nicht den Arbeitsplatz wechseln muss.

Natürlich existierten auch zuvor Einheitlichkeiten zwischen Programmen, aber der Nutzer konnte sich nie darauf verlassen, dass diese gleich funktionieren. Vereinfacht stellt eine GUI eine Sammlung von Programmroutinen zur Verfügung, um ein einheitliches Aussehen zu bewirken. So wie DOS’ Minimalanforderungen die Standards für Kommandozeilenprogramme setzten, so definierte eine GUI die Standards für die aufsetzenden Programme, allerdings nicht nur in optischer, sondern auch in funktionaler Hinsicht.

Damit waren GUI-Hersteller in einer Zwitterrolle. Einerseits bot eine GUI allein keine Funktionalität, für die man Geld ausgeben wollte, sondern eben nur die Möglichkeiten für die grafische Bedienung. Erst Programme, die die in der GUI gesetzten Standards einhielten, indem sie die Programmroutinen aufriefen, anstatt eigene Lösungen zu programmieren, lieferten das Kaufargument. Das bedeutete ein Umdenken auf allen Seiten. Nicht der Programmierer entschied, wie sein Programm den Nutzer Dateien speichern lässt, sondern Apple definierte dies, und der Programmierer rief nur die Mac-Programmroutinen auf. Dazu müssen die Speicher-Routinen so sinnvoll konzipiert und fehlerfrei programmiert sein, dass sie zuverlässig mit jedem Fall von Speicherungen zurechtkommen.

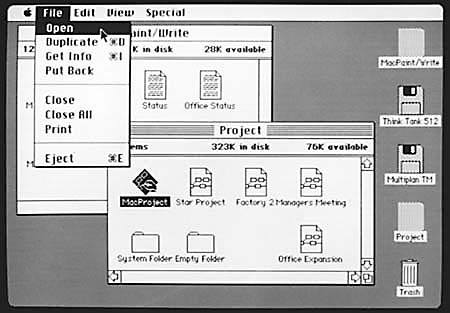

Der erste Macintosh legte 1984 die Basis für eine einheitliche Bedienung: Am oberen Rand die Menüleiste, frei verschiebbare Fenster, klare Icons, die mit der Maus bewegt werden konnten.

Beim Start des Computers landete man automatisch in dem Programm Finder. Bemerkenswert ist – auch aus heutiger Sicht –, dass der Mac viele Funktionen in Software abbildete, die eigentlich Hardware-Funktionen sind: Der Computer verfügte über keinen Disketten-Auswurfknopf, Disketten wurden via Mausklick ausgeworfen; auch wurde das Gerät über einen Menübefehl ausgeschaltet. Die Trennung zwischen Soft- und Hardware war aufgehoben: War das Systemprogramm beendet, schaltete sich der Rechner aus. Es gab keine Befehlszeile, wo er auf Eingaben hätte warten können.

Dagegen wurde Windows 3 beendet und der Computer erst danach ausgeschaltet, wenn er im DOS-Modus auf Eingaben wartete. Erst mit Windows XP funktionierte auch bei PCs das Abschalten via Software zuverlässig, sodass beim Beenden („Herunterfahren“) von Windows auch der Rechner ausgeschaltet wird.

Die frühen Mac-Systeme kannten noch kein ↑ Multitasking, es konnte jeweils nur ein Programm laufen. Nach dem Start lief der Finder, in dem man seine Dateien verwaltete, Programme startete oder Dokumente öffnete. Beim Start eines neuen Programms wurde der Bildschirm geleert, dann erschien das Programm. Durch die Guidelines wirkte es aber nicht wie etwas völlig anderes, sondern die Menüzeile am oberen Bildschirmrand, gleiche Bedienelemente und gleiche Bedienweisen führten dazu, dass trotz der Programmvielfalt der Eindruck von etwas Einheitlichem entstand. Die Menübefehle funktionierten in jedem Programm gleich. Drag & Drop gab es damals zwar nicht zwischen verschiedenen Programmen, sondern nur innerhalb eines Dokuments. Aber die systemweite Zwischenablage erlaubte es, mittels Ausschneiden/Kopieren und dann Einfügen stets Inhalte aus einem Programm in ein anderes zu übertragen.

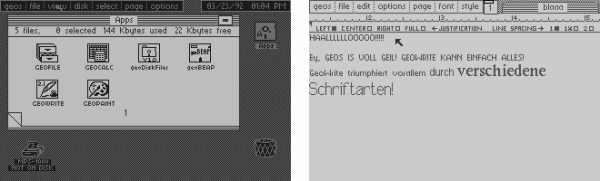

Das seinerzeit populäre Geos auf dem C 64 war ebenso limitiert und dem frühen Mac sehr ähnlich. Da jeweils nur ein Programm laufen konnte, musste auch hier zwischen „Desktop“ (das Finder-Pendant) und dem jeweiligen Programm gewechselt werden. Das Programm füllte stets den gesamten Bildschirm, allerdings gab es nicht die Möglichkeit, mehrere Fenster auf einmal zu öffnen.

Das Geos-Farbschema konnte zwar angepasst werden, aber der Bildschirm war immer gleich aufgebaut. GeoWrite nutzte den meisten Bildschirmplatz für das Dokument. Neben dem Menü zeigte ein Seitenüberblick, wo man sich auf einem Din-A4-Blatt befand; mangels Scrollbalken, wählte man mit ihm den Dokumentausschnitt und wechselte zwischen rechtem und linkem Seitenbereich. Oben rechts stand der „Fenstertitel“ (Dateiname). [Abbildungen: C64-Wiki, zimmers.net/geos]

Der Arbeitsbildschirm war definiert und konnte nicht verändert werden. Auf dem Desktop gab es einen fest vorgegebenen „Fensterbereich“, in dem der Inhalt von Disketten angezeigt wurde. Rechts daneben waren die Datenträger (zumeist Disketten oder ↑ RAM-Erweiterungen als Laufwerk) abgebildet, um zwischen diesen umzuschalten. Im Bereich unterhalb des Fensters konnte man Dateien ablegen, um sie beispielsweise auf einen anderen Datenträger zu kopieren. In Anbetracht seiner technischen Grenzen (0,96 Megahertz-Prozessor mit 64 Kilobyte Arbeitsspeicher) war das System erstaunlich mächtig, aufgeräumt und nutzbar.

Der Mac benötigte eine 400-Kilobyte-Diskette für das System. Mit der Einladung, direkt etwas zu tun, rüttelte er am Verständnis von Computern. Es dauerte allerdings lange, bis sich der Erfolg auch in den Verkaufszahlen nachhaltig einstellte. Mit seinem Apple-][-Computer hatte Apple seit 1977 einen erfolgreichen PC im Angebot. Das letzte Modell wurde 1993 produziert. Auch wenn der Apple ][ historisch nicht die selbe Bedeutung hat wie der Mac, hielt er doch die Firma wirtschaftlich über Wasser und war eine populäre Computerplattform, für die zahlreiche Programme und auch mehrere GUI-Programme existierten.

Verbreitung

Als der Mac erschien, fehlte vielen zunächst das Verständnis dafür, warum man eine Maus benötigen sollte, um einen Computer zu bedienen. Doch die bald erscheinenden Programme demonstrierten die Fähigkeiten des Mac besser als jede Werbebroschüre und stellten die wirksamste Werbung dar. Bereits 1984 veröffentliche Microsoft „Word for Macintosh“. 1985 erschien die Tabellenkalkulation Microsoft „Excel“, die als Nachfolger von MultiPlan den Standard für Tabellenkalkulationen setzte. 1985 brachte Aldus das Layoutprogramm PageMaker heraus. 1987 erschienen das Layoutprogramm Quark XPress und das Foliengestaltungsprogramm PowerPoint. Diese konnten so nur auf dem Mac mit seinen grafischen Möglichkeiten entstehen. Vor allem die Layout-Software entwickelte sich zu „Killer-Applications“, also zu Programmen, deretwegen man extra bestimmte Technik kauft. Die Eignung für Desktop Publishing (↑ DTP) ließ den Mac erst erfolgreich werden.

Die Programme und ihr effektives Zusammenspiel profitierten vom „Mac-Feeling“. Alles, was eine gleiche Funktionalität hat, funktioniert auch gleich; dadurch sind neue Programme und Arbeitsmöglichkeiten schnell zu lernen. Das Speichern fand sich beispielsweise immer im File-Menü (also immer im zweiten Menü), hatte als Standard-Tastenkürzel [Cmd] [S], das erscheinende Fenster, wo man Dateinamen und Speicherort einstellt, war in jedem Programm gleich. Dadurch ist eine der wichtigsten Funktionen – nämlich das Sichern seiner Arbeitsergebnisse – immer ohne Suchen erreichbar, was bei der Arbeit Sicherheit vermittelt. Auch andere GUIs boten zwar diese Einheitlichkeit. Es waren jedoch die tausend Kleinigkeiten, die den Mac hervorstechen ließen: die Fähigkeiten zu Wysiwyg bei jeder Schrifteingabe, die universelle Zwischenablage für den Transport von Daten zwischen Dokumenten verschiedener Programme, die grafischen Möglichkeiten, die Fokussierung auf Benutzer und Anwender statt Kunden oder Manager, die zuverlässige Zusammenarbeit von Hard- und Software.

Der heute so mächtige Photoshop wurde 1989 (für den Mac) vorgestellt und entwickelte sich mit der ersten Version ab 1990 bald zum Standard für Bildbearbeitung. Nachdem im 19. Jahrhundert Malerbedarf, vor allem die einst teuren Ölfarben, vergleichsweise billig wurden, führte das zu einer Demokratisierung der Malkultur. Künstler waren nicht mehr von Auftraggebern, die ihnen die Farbe bezahlten, abhängig, sondern konnten selbst in bescheidenen Verhältnissen leben und dennoch ihrer Kunst frönen. Ohne diese Entwicklung wäre Malen vermutlich kein Hobby geworden, hätten van Gogh oder Modigliani nicht ihre Bedeutung für die Kunstgeschichte erreicht und wären höchstwahrscheinlich nicht so viele verschiedene Kunstrichtungen im ausgehenden 19. und beginnenden 20. Jahrhundert entstanden.

Im Internet finden sich zahllose Belege, wie sich kreative Menschen austoben – ganz einfach, weil sie die Werkzeuge dafür besitzen können. Auch wenn eine Photoshop-Lizenz teuer ist, so ist sie doch für viele erschwinglich; dass das Programm oft unlizensiert verwendet wird, erhöht die Nutzerschar zusätzlich. So wie sich die Künstler in früheren Zeiten von ihren Auftraggebern emanzipierten, so können Computernutzer heute die Werke schaffen, nach denen ihnen der Sinn steht. Sind die Programme einmal vorhanden, besteht das einzige Investment in der Zeit und der Stromrechnung.

In den 1990ern gab es keine Publikation mehr, die ohne Computer erstellt wurde. Binnen weniger Jahre war die Layout-Landschaft umgekrempelt und verabschiedete sich vom Bleisatz.Auf http://photoshopdisasters.blogspot.com/ sind zahlreiche Beispiele für Photoshop-Missbrauch oder inkompetente Anwendung gesammelt. Kaum ein veröffentlichtes Foto hat nicht ausführliche Photoshop-Bearbeitungerfahren. Der Grat zwischen Fotoverbesserung und -fälschung ist schnell überschritten, wenn Gesichter aufgehübscht werden, wenn Landschaften aus verschiedenen Himmeln und Hintergründen entstehen, wenn sich Details ändern, wenn Hautfarben wechseln oder Pickel und Schweißflecken verschwinden. Da es sich niemand leisten kann, ein unbearbeitetes Foto zu veröffentlichen, ist bei jedem Foto Skepsis angebracht. Da jeder die Werkzeuge besitzen kann, ist jeder in der Lage, das Abbild der Welt zu verbessern – oder zu fälschen, je nach Interessenlage. Die Idee, am Bildschirm komponierte oder stark bearbeitete Fotos bei der Veröffentlichung mit einem „[M]“ zu versehen, hat sich bislang nicht durchgesetzt.

Mit der Demokratisierung geht eine Ent-Professionalisierung einher. Autodidakten erzielen Ergebnisse, die scheinbar denen von gelernten Profis in nichts nachstehen. Die Mächtigkeit der Technik verführt dazu, dass sich immer mehr Personen für „Macher“ halten. Der Manager, der keine Sekretärin mehr beschäftigt, sondern seine Schreiben selbst aufsetzt, wird weder die Schreibgeschwindigkeit noch die orthografische Sicherheit dieser Fachkraft erreichen. Der Kleinunternehmer ist selten ein guter Web-Designer. Textredakteure liefern selten spannend layoutete Zeitungsseiten.

Jeder kann mit der verfügbaren Technik alles tun. Doch wenn jeder alles kann, kann niemand etwas richtig. Es fällt zunehmend schwer, zu entscheiden, ab wann man eine Arbeit an einen Profi abtritt. Da das Publikum oft aus „enthusiastischen Laien“ besteht, verliert Profi-Arbeit scheinbar an Wert, denn nur gelernte und erfahrene Anwender erkennen den qualitativen Unterschied zwischen professionellen und Laien-Werken. Wenn der Unterschied kaum auffällt, genügt es, wenn Laien die Arbeit erledigen, ist eine häufige Denkweise von Computertätern und Alles-Selbst-Mach-Opfern.

Grafische Betriebssysteme

Nach einer offiziellen Ankündigung 1983 erschien 1985 die erste Version von Microsoft Windows, die allerdings hohe Hardware-Anforderungen stellte; es existierten auch kaum passende Programme. Bis Windows 3 ist die Unterscheidung zwischen Programm und Betriebssystem schwer zu treffen. Versteht man ein Betriebssystem als Software, die es anderer Software ermöglicht zu funktionieren, waren Windows 1 bis 3 natürlich Betriebssysteme, sie selbst basierten wiederum auf DOS. Betriebssysteme vermitteln zwischen Programm und Hardware, sodass nicht jedes Programm die Grafikkarte oder Soundkarte direkt ansteuern muss, sondern dem Betriebssystem mitteilt, welche grafischen Effekte und welche Töne benötigt werden, und das Betriebssystem kümmert sich um die Umsetzung. Auch der Umgang mit Datenträgern (Disketten, Festplatten, CD-ROMS etc.) und das Ansteuern von Druckern gehört dazu. DOS-Programme beispielsweise konnten nur mit Druckern kommunizieren, die sie jeweils kannten oder die einen Pseudo-Standard (meist ein älteres populäres Gerät) emulierten.

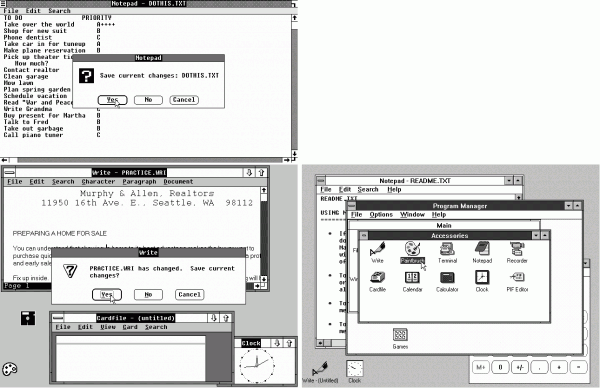

Windows 1 (1985), Windows 2 (1987) und Windows 3 (1990). [Abbildungen: toastytech.com/guis]

Mit dem Alto war die Machbarkeit einer GUI bewiesen, und zahlreiche Entwickler – auch außerhab von Apple – erkannten die neuen Chancen, durch die grafische Oberfläche einen „Computer für Jedermann“ zu schaffen. Auf den PCs konkurrierten mehrere GUIs. Für Visi On der Firma VisiCorp gab es eine Textverarbeitung, Tabellenkalkulation und ein Grafikprogramm – alle von VisiCorp entwickelt. Wegen der hohen Hardwarekosten war Visi On erfolglos, und VisiCorp musste Konkurs anmelden. DESQview von Quarterdeck erlaubte das gleichzeitige Ausführen von DOS-Programmen und war die erfolgreichste Multitaskingumgebung für DOS, wurde aber bald von Windows verdrängt. IBMs TopView benutzte den Textmodus und konnte DOS-Programme ausführen, aber nur speziell für TopView entwickelte Anwendungen liefen gleichzeitig und ermöglichten den Datenaustausch mittels Kopieren und Einfügen. GEM von Digital Research war nicht multitaskingfähig und lehnte sich an die GUI, wie sie im PARC entwickelt wurde, an.

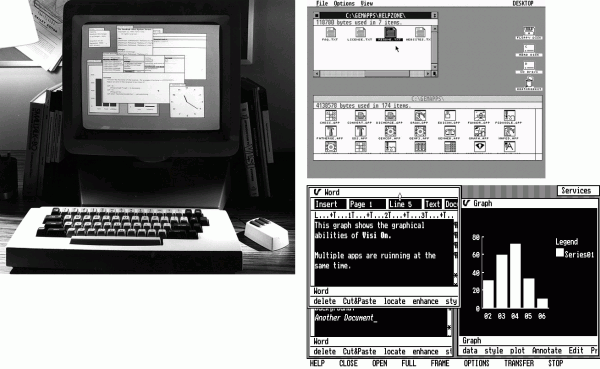

Eine kleine Rund- und Zeitreise durch die verschiedenen grafischen Oberflächen bietet das Internet, beispielsweise http://toastytech.com/guis oder www.guidebookgallery.org. Der Alto im PARC (links), GEM (oben rechts) und Visi On (unten rechts).

Die GUIs unterschieden sich hinsichtlich der konkreten Gestaltung, die allgemeinen Bedienprinzipien (Fenster, Icons, Menüs, Mauszeiger, ↑ WIMP) waren bei allen gleich. Mit einem Zeigegerät konnten der Textcursor platziert, ein Element markiert und verschoben sowie die Menüs bedient werden. Sämtliche verfügbaren Befehle waren darin aufgeführt und warteten darauf, dass der Mauszeiger ihren Menütitel aktivierte, damit sie sichtbar würden und angeklickt werden könnten. Die GUI übernahm quasi die Aufgabe, die vom Nutzer geklickten Befehle in Kommandozeilenbefehle zu übersetzen; die Kommandozeilenschicht übersetzte diese Befehle anschließend in Anweisungen für den Prozessor.

Ab 1996 gab es nur noch eine GUI für PCs: Windows 95. Mit Windows 3 hatte Microsoft seine Vorherrschaft in den Bereichen der grafischen Oberfläche und der darunterliegenden Kommandozeile zementieren können. Denn alle damaligen GUIs basierten auf einer Kommandozeile, von denen MS-DOS die verbreitetste war. Wollte man Windows 3 auf einem anderem System als DOS installieren, erhielt man eine Fehlermeldung, die – wie ein Gericht befand – nicht gerechtfertigt war und Nutzer verunsicherte.

Mit pompösem Marketingaufwand wurde Windows 95 der Öffentlichkeit vorgestellt. Allerdings basierte es weiterhin auf DOS und war in erster Linie für Privatanwender gedacht. Windows NT dagegen war ein völlig neues System, das für den Einsatz in Unternehmen vorgesehen war.Jedes Betriebssystem basiert auf Kommandozeilen, wie ein Rechnerabsturz demonstriert. Der Unterschied liegt darin, ob eine Bedienung über diese als Standardnutzung vorgesehen ist. Die Unterschiede bestanden im technischen Unterbau, der keine für den Nutzer dargestellte bzw. erreichbare Kommandozeile mehr beinhaltete.Optisch glich Windows NT erst Windows 3, mit der nächsten Version dann Windows 95. Zunächst hatte sich Microsoft mit IBM verbündet, um ein grafisches System für PCs zu entwickeln, das DOS ablösen und die Ansprüche an ein modernes Betriebssystem erfüllen sollte: Stabilität, Speicherschutz, Multitasking, objektorientierte Programmierung. Noch bevor das System fertiggestellt war, ging Microsoft 1991 eigene Wege und brachte 1993 Windows NT heraus, in dem an vielen Stellen Computercode aus der Kooperation enthalten war. IBM veröffentlichte das System in Fortführung seiner seit 1987 bestehenden Betriebssysteme „IBM BS/2“ als „IBM OS/2“ schließlich selbst.

Ein neuer Standard

Den Wettbewerb auf dem PC-Markt hatte Microsoft damit ausgeschaltet. Erstens erhielt weiterhin jeder PC-Käufer eine Windows-Lizenz, gefühlt umsonst, de facto bezahlt der Hersteller die sogenannte Microsoft-Steuer (heute etwa 30 Dollar pro Gerät), damit dieses mit Windows ausgeliefert werden kann. Zweitens hatten Micro\-soft und IBM zuvor kräftig die Werbetrommel für OS/2 gerührt, sodass alle Softwareentwickler sich auf dieses System konzentrierten. Als Windows erschien, hatte nur Microsoft ein Programmpaket im Angebot, das perfekt zum neuen System passte – so zementierte es sein Monopol im Bereich der Office-Software, denn diesen Vorsprung konnte niemand wieder ausgleichen. Drittens stellte OS/2 höhere Anforderungen an die Hardware. Viertens konnte OS/2 auch Windows-3-Programme ausführen, weshalb Programmierer ihre alten Programme nicht an OS/2 anpassten, für neue war der Marktanteil von OS/2 dann allerdings wieder zu gering. Aufgrund seiner technischen Überlegenheit konnte sich OS/2 in einigen wenigen Nischen durchsetzen, beispielsweise im Bankenbereich.

In diesem Zusammenhang wird einmal mehr deutlich: Kunden kümmern sich kaum um technische Details, sondern lassen sich gern vom schöner scheinenden System verführen. Positiv formuliert: Um am Markt erfolgreich zu sein, braucht es nicht nur die bessere Technik, sondern auch die bessere Präsentation.

Weltweit haben sich heute grafische Benutzeroberflächen zur Computerbedienung durchgesetzt. Diese bewirken dreierlei. Zunächst wird die Computerbedienung zum optischen und akustischen Erlebnis; die scheinbar direkte Manipulation beispielsweise durch das Ziehen eines Icons auf den Papierkorb bildet einen realen Vorgang virtuell nach. Zum zweiten werden die abstrakten Vorgänge – beispielsweise das Entfernen eines Datei-Eintrags aus dem Datenträgerverzeichnis, also das Unauffindbar-Machen, das „Löschen“ – visualisiert und damit ohne rationale Interpretation einer Kommandozeilenausgabe verständlich. Zum dritten entfremden die GUIs die Benutzer von der Technologie, indem sie das eigentliche Wirken des Computers verbergen.

Der Nutzer gibt also nicht mehr dem Rechner den Befehl „Lösche die Datei“, sondern vollführt die Aktion und verlässt sich darauf, dass die grafische Oberfläche dies wunschgemäß in den passenden Computerbefehl übersetzt und diesen ausführt. Eingaben erfolgen dabei analog, sie sind damit ungenau und verlieren durch die Übersetzung in das ↑ digitale Raster an Inhalt. Bei einer mechanischen Schreibmaschine ist beispielsweise durch unterschiedlich intensiven Tastenanschlag eine Varianz in der Schriftbildsättigung zu erzeugen – ein Computer zeigt alle Buchstaben gleich schwarz, die Intensität des Anschlags wird nicht ausgewertet, sondern nur, ob eine Taste gedrückt wurde oder nicht.

Die Interaktion zwischen Mensch und Maschine änderte sich von den 1970ern bis in die 1990er Jahre also grundlegend: Weg vom direkten Befehlen, hin zu einem Selber-Tun, und der Computer wiederholt die Aktion intern. Ich lösche die Datei metaphorisch selbst, indem ich sie in den Papierkorb lege. Der Computer wiederholt meine Aktion in seiner binären Realität und entfernt die Datei. Der Nutzer muss nicht die konkreten Befehle kennen, sondern die allgemeine Metaphernwelt, nach der die GUI aufgebaut ist.

Die technische Demokratisierung führt letztlich zu einer Illusion von Qualität. Angefangen hat alles mit der grafischen Benutzeroberfläche, die die Computer den Menschen nahebrachten, sodass diese sich ermächtigt und kompetent fühlten. Zahlreiche Vorlagen für Standardaufgaben geben das Gefühl, eine Aufgabe zu meistern. Doch ist eine Aufgabe nicht mehr mit Vorlagen oder auf bekannten Wegen zu lösen, trennt sich die Spreu vom Weizen.

Im Privatbereich gelten andere Ansprüche als im Beruf. Wenn jemand in der Lage ist, eine kleine Vereinsinternetseite zu basteln und zu pflegen oder eine Hochzeitszeitung zu gestalten oder ein Haushaltsbuch zu führen, bedeutet das nicht, dass diese Fähigkeiten als Basis eines Berufs taugen. Diese Auswirkungen des virtuellen Schreibtischs waren in den 1980er Jahren kaum absehbar.

Überblick über „Der Apple-Faktor, Band I“:

1. Einleitung

2. Die Anfänge

3. Von der Taste zum Touch

4. Von der Anweisung zum Klick

5. Virtueller Schreibtisch

6. Vom Buchstaben zur Transparenz

7. Vom Einzelplatz zum Netz

8. Von der Philosophie zum Kompromiss

9. Die wunderbare Welt der Software

10. Zum Ende: Versuch eines Vergleichs zwischen Mac OS X und Windows Sieben

Epilog: Eine neue Zeit

ein Kind der 70er • studierter Anglist/Amerikanist und Mediävist (M.A.) • wohnhaft in Berlin • Betreiber dieses Blogs zanjero.de • mehr über Alexanders Schaffen: www.axin.de ||

ein Kind der 70er • studierter Anglist/Amerikanist und Mediävist (M.A.) • wohnhaft in Berlin • Betreiber dieses Blogs zanjero.de • mehr über Alexanders Schaffen: www.axin.de ||

Pingback: Der Apple-Faktor: Einleitung | zanjero.de

Pingback: Der Apple-Faktor, Band I | zanjero.de