Der „personal computer“ (PC) entstammt kulturell der Hippie-Bewegung. Im Gegensatz zu einem Großrechner mit angeschlossenen Terminals gibt es keine zentrale Instanz, die entscheidet, was möglich ist und was nicht. Jeder Computernutzer kann „seinen“ Computer selbstbestimmt verwenden. Er oder sie entscheidet, welches Betriebssystem darauf läuft, welche Programme vorhanden und welche Geräte angeschlossen sind.

Der Beitrag bildet das siebte Kapitel im Buch „Der Apple-Faktor“. (bei amazon.defür 14,90 Euro bestellen)

Die Computer-Power wurde mit der Abkehr von Großrechnern individualisiert. Die PCs waren zwar nicht so leistungsfähig wie die Großrechner, aber auch nicht so schwerfällig. Um an einem Großrechner etwas zu ändern, muss erst die Hierarchie, die den Großrechner betreibt, überwunden werden: EDV-Angestellte, Abteilungsleiter, Manager, Controller, Programmierer. Ein Fehler kann dabei wertvolle Rechenzeit kosten und großen Schaden anrichten. Läuft auf einem PC etwas nicht, kann der Nutzer sich die Zeit nehmen und ihn neu installieren.

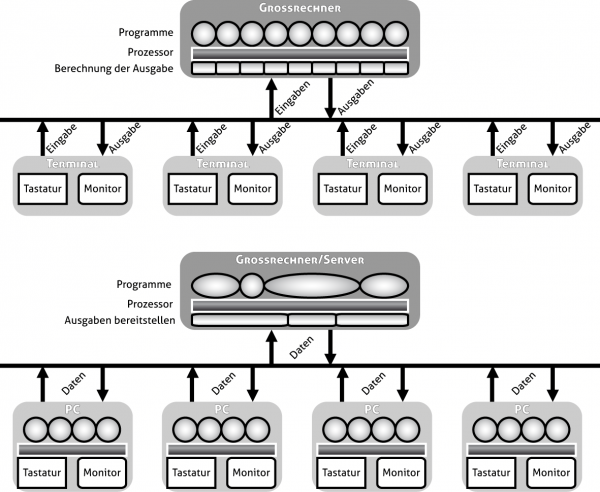

Via Terminals waren die Nutzer an die Großrechner angebunden, sie hatten also eine Tastatur und einen Bildschirm, auf dem der Rechner die für sie bestimmten Ausgaben anzeigte und von der er ihre Eingaben entgegennahm. Das Terminal konnte dabei viele Kilometer vom eigentlichen Rechner entfernt stehen. Es gab Großrechner, die mehrere Hundert Terminals gleichzeitig bedienten. Bei hundert Nutzern muss ein Rechner also hundert Tastaturen abfragen und hundert Bildschirmausgaben berechnen.

Die Aufgaben des Großrechners: Eingaben der Terminals auswerten, benötigte Programme laufen lassen und für jedes Terminal die Bildschirmausgabe berechnen. Dagegen lässt jeder PC seine eigenen Programme laufen. Auf dem Server sind nur wenige aktiv – zum Daten empfangen oder senden (z. B. Datenbanken oder Datendienste). Der PC wertet seine Eingaben selbst aus und schickt nur Daten zum Server, die für diesen nötig sind. Die Daten vom Server rechnet der PC selbst so um, dass sie auf dem Bildschirm dargestellt werden. [Abbildung: Autor].

Da Terminals nur über Kommandozeilen verfügten, hielt sich der Rechenaufwand in Grenzen; eine direkte Manipulation des Bildschirmraumes war unmöglich. Man kann die folgende Entwicklung theoretisch auf zwei Arten beschreiben. Aus Sicht des Netzwerkes wurde der Datenverkehr reduziert, indem die Terminals leistungsfähiger wurden, sie verarbeiteten ihre Eingaben und berechneten ihre Ausgaben selbst. Aus Sicht der beteiligten Rechner wurden die Computer vom Netzwerk unabhängig, erhielten also alle Komponenten, über die ein Großrechner verfügte, ohne jedoch deren Leistungsfähigkeit zu erreichen. Diese ist auch nicht nötig, da nur die Eingaben eines Nutzers verarbeitet und nur eine Ausgabe berechnet werden muss. Für bestimmte Aufgaben oder um Daten zwischen den Computern auszutauschen, können sich die Computer mit einem Netzwerk verbinden. Dabei werden auf den anderen Computer keine Rechenaufgaben ausgelagert, sondern nur Daten mit ihm ausgetauscht.

Das SETI-Projekt, das nach Leben fernab unseres Planeten sucht, hat die Entwicklung teilweise umgedreht. Auf einem Großrechner werden die Daten gesammelt und in handliche Portionen zerlegt. Computer auf der ganzen Welt, die an das Internet angeschlossen sind, nehmen in Rechenpausen Kontakt mit dem Seti-Rechner auf, erhalten eine Datenportion, verarbeiten die Daten und senden die Ergebnisse zurück. Während der Großrechner früher die Berechnungen zentral ausführte, während Ein- und Ausgabe verteilt stattfanden, findet bei Seti die Berechnung verteilt statt, und die Ein- und Ausgaben laufen zentral auf dem Seti-Rechner. Diese Entwicklung war möglich geworden, da die PCs über genügend Rechenkapazität verfügten, sodass sie etwas davon abgeben können, ohne dass der Nutzer dies spürt.

Etwas allgemeiner formuliert, sind heutige Computer so leistungsfähig, dass die strikte Trennung zwischen reinen Ein-/Ausgabe-Geräten, Computern mit Netzwerkanbindung und Großrechnern zur zentralen Datenverarbeitung aufgehoben scheint. Jedes Betriebssystem bringt Serverfunktionalität mit, sodass jeder Rechner zumindest in einem kleinen oder Heimnetzwerk als Server fungieren kann. Die Aufgaben werden je nach Erfordernis zwischen den Computern verteilt. Diese gegenseitige Unabhängigkeit ist von Anarchie jedoch weit entfernt. Denn stets behält ein Computer den Überblick, managt die Datenpakete oder Ein- und Ausgaben. Eine, wenn auch flache, Hierarchie mit mindestens einem Computer, der die zu bewältigende Aufgabe verwaltet, bleibt bestehen.

Gemeinsame Sprache

In der PC-Ära gehört jeder Computer zu einer Person. Damit mehrere Personen miteinander Informationen (Daten) austauschen können, müssen sie die selbe Sprache verwenden. Computer können nicht auf Körpersprache zurückgreifen, sondern sind auf eine sehr korrekte Anwendung der Sprachregeln angewiesen. Das Computer-Esperanto für den Datenaustausch bildet TCP/IP. Dieses Transmission Control Protocol/Internet Protocol ist eine Sammlung von Netzwerkprotokollen und bildet die Basis für das Internet.

Der Begriff „Protokoll“ verdeutlicht den Unterschied zur „Sprache“. Sprache kann sich frei weiterentwickeln, lässt Mehrdeutigkeiten zu, reagiert spontan auf Veränderungen; Protokolle dagegen sind festgeschriebene Abläufe und genaue Prozederes, deren Verletzung unerwünscht ist. In der Großrechner-Ära bestimmte jeder Hersteller, wie Terminals mit Großrechnern kommunizieren, meist gab es herstellerspezifische Kabel und Anschlüsse, sodass Terminals von Fremdherstellern nicht angeschlossen werden konnten.

Um Daten zwischen Computern (ob nun PC oder Großrechner) auszutauschen, haben Hersteller mehrere Möglichkeiten. Sie können Hard- und Software liefern, um diese in anderen Rechnern zu installieren. Dann hätten sie die Kontrolle und Verantwortung, dass alles reibungslos funktioniert. Sie können auf bestehende Strukturen (wie Telefonleitungen) aufsetzen und benötigte Zusatzhard- und -software bereitstellen. Sie können bestehende Lösungen anderer Anbieter integrieren (beispielsweise das NetWare, das Anfang der 1980er die einzige vielseitige Möglichkeit darstellte, DOS-Computer zu vernetzen). Sie können eine frei verfügbare Variante integrieren. Sie können mit anderen Herstellern gemeinsam einen Standard entwickeln oder sich einem Standard-Gremium anschließen.

Die Erfahrung zeigt, dass ein gemeinsamer Standard meist weniger leistungsfähig ist als eine Speziallösung. Die Speziallösung funktioniert für bestimmte Aspekte optimal, beispielsweise AppleTalk zur spontanen Ad-hoc-Verbindung von Mac-Rechnern oder NetWare, dessen IPX/SPX-Netzwerkprotokoll einen höheren Datendurchsatz bietet als TCP/IP. Der Nachteil für die Kunden besteht darin, dass nicht alle Geräte einfach in ein solches Netzwerk integriert werden können. Das AppleTalk-Protokoll bietet eben nur alle Vorteile, wenn man sich in einem reinen Mac-Netzwerk befindet. Da solche Speziallösungen von verschiedenen Unternehmen entwickelt werden, verwenden sie oft eigene Anschlüsse (wie der AppleTalk-Anschluss), können den Standard radikal weiterentwickeln, sodass ältere Geräte nicht mehr verwendet werden können, oder die Unterstützung kurzerhand einstellen.

Ein gemeinsamer Standard schließt möglichst viele Geräte ein, ältere, aktuelle und künftige. Es gibt keine sprunghafte Weiterentwicklung. Der Standard stellt im Guten wie im Schlechten den kleinsten gemeinsamen Nenner dar. Nahezu alle Netzwerkbedürfnisse können über TCP/IP bedient werden, aber in keinem Anwendungsfall erreicht es die gleichen Vorteile (einfache Einrichtung, Geschwindigkeit, Zuverlässigkeit) wie eine jeweilige Speziallösung. Die Vorteile liegen auf einer anderen Ebene: Es ist meist billiger, als eine eigene Lösung zu entwickeln – für Hersteller und Kunden. Es verfügt über eine große Anwendungsvielseitigkeit und Zukunftssicherheit, da kein Hersteller allein dafür verantwortlich ist. Es ist auf vielen Plattformen verfügbar, sodass eine netzwerkabhängige Dienstleistung nicht auf bestimmte Computer angewiesen ist.

Das World Wide Web ist das anschaulichste Beispiel dafür. Vernetzt waren Computer bereits in den 1970ern, doch meist nur lokal oder für bestimmte Spezialanforderungen auch über große Distanzen. In den 1980ern gehörten eMail, Datenübertragung (File Transfer Protocol, FTP), Newsgroups, Mailinglisten zu etablierten Funktionen. Doch die breite Nutzung dieser Möglichkeiten auch durch Nicht-Computer-Affine trat erst in den 1990ern ein.

Hallo Welt

1991 hat Tim Berners-Lee das Internet erfunden. Dieser Satz ist ebenso richtig wie falsch. Der 2004 zum Sir Geadelte hatte 1989 am Kernforschungszentrum CERN begonnen, die verschiedenen vernetzten Kommunikationsmöglichkeiten miteinander zu integrieren. Er kreierte die Hypertext Markup Language (↑ HTML), die die Basis für alle Internetseiten bildet (im Browser über „Quelltext anzeigen“ einzusehen). Am 6. August 1991 wurde das World Wide Web zur allgemeinen Nutzung freigegeben. Berners-Lee hatte den ersten Webserver aufgesetzt, eine allgemeine Konzeption für das World Wide Web veröffentlicht und gab der Welt HTML.

Heute wird mit „Internet“ meist das World Wide Web gemeint, doch das WWW ist nur ein Bestandteil des Internet, zahlreiche Dienste (wie eMail, FTP, Chatprotokolle) gehören ebenso zum Internet. Der Unterschied wird auch in Berner-Lees eigener Beschreibung deutlich: „The WorldWideWeb (W3) is a wide-area hypermedia information retrieval initiative aiming to give universal access to a large universe of documents.“Übertragung: Das World Wide Web ist eine großangelegte medienübergreifende Informationsbereitstellungsinitiative mit dem Ziel, unbeschränkten Zugang zu einem großen Universum von Dokumenten zu geben. Diese Dokumente liegen auf Webservern, wo sie mit einem Browser von einem anderen Rechner aus abgerufen werden können. Die Dokumente können aufeinander verweisen (Links) und sind strukturiert (beispielsweise durch Überschriften in mehreren Hierarchieebenen).

Berners-Lees Leistung besteht darin, zahlreiche Ideen, Konzepte und Lösungen zu einem funktionierenden System verknüpft zu haben. Dabei hatte er die Realitäten des Marktes vor Augen und setzte auf offene Standards, sodass das WWW keiner Einzelperson gehört oder von einem Einzelunternehmen dominiert werden kann. Heute gibt es fünf relevante Browser: Internet Explorer, Mozilla Firefox, Apple Safari, Google Chrome und Opera.Der Browserkrieg in den 1990ern zwischen Netscape und Internet Explorer, der Microsoft Glaubwürdigkeit und viel Zeit vor Gericht kostete, ist vielerorts ausführlich und kompetent beschrieben worden. Es gibt zahlreiche Webserver-Systeme: Unix oder Linux mit Apache-Server, Windows-Server, Server von Sun, IBM, auch „Normal-PCs“ können theoretisch als Webserver fungieren. Alle stellen die selben Netzwerkdienste bereit. Das W3-Konsortium wacht über HTML und entwickelt es gemeinsam mit den Browserherstellern weiter.

Damit gilt für HTML das gleiche wie für Netzwerkprotokolle: Es ist der kleinste gemeinsame Nenner. Für Spezialaufgaben (Musik übertragen, Videos präsentieren, miteinander kommunizieren) gibt es im langjährigen Standard HTML 4 keine eingebaute Lösung. Dafür ist zusätzliche Software nötig – und das ist eine Stärke von HTML: Es kann andere Möglichkeiten integrieren, und für den Normalnutzer ist nicht ersichtlich, dass er Funktionen nutzt, für die sein Browser auf Extraprogramme zurückgreift. Um Musik oder Videos abzuspielen, werden QuickTime, MediaPlayer oder Flash genutzt, und diese Dateien innerhalb einer Webseite dargestellt. Für die direkte Kommunikation startet der Browser oft ein Java-Programm, das ebenfalls innerhalb der Webseite ablaufen kann. Mit HTML 5 sollen interaktive Elemente standardisiert werden und Musik- und Video-Dateien direkt im Browser abspielbar sein, eben ohne Flash, QuickTime oder Windows Media Player. Damit benötigt der Nutzer nur noch einen aktuellen Browser, ohne sich um Zusatzprogramme zu kümmern. Theoretisch jedenfalls, denn in der Praxis spielt der Patentschutz für die populären Verfahren, um Musik- und Video-Dateien zu kodieren, eine Rolle.

Intensiv kümmern sich Google, Apple und Mozilla darum, den HTML-Standard weiterzuentwickeln und herstellerunabhängig zu gestalten. Denn alle drei Browseranbieter haben erkannt, dass das Internet nur dann effektiv und für die Nutzer zuverlässig funktioniert, wenn sich alle Browser an einen gemeinsamen Standard halten. Auch Microsoft hat sich wider Erwarten offen zu HTML 5 bekannt. Google stellt einen erworbenen ↑ Codec zur Videokomprimierung der Allgemeinheit kostenlos zu Verfügung, um einen gemeinsamen Video-Standard zu etablieren, der nicht von Patentschutz abhängt, wie der populäre H264-Codec.

Ein Internet, das nur mit einem Browser oder Betriebssystem korrekt funktioniert, hilft keinem. Denn das Internet ist überall. Allein für Computer gibt es drei Betriebssysteme und für Mobiltelefone ebenfalls mehrere. Kein Einzelhersteller kann alle Plattformen gleichermaßen bedienen, wie Adobe mit Flash bewiesen hat. Die Versionen für Mac, Windows, Linux und Mobilgeräte unterscheiden sich frappierend. Es ist nie garantiert, dass eine Flash-Anwendung auf jedem Gerät funktioniert. Das Internet lebt von seinen Inhalten und Nutzern, daher dürfen diese nicht von bestimmten Unternehmen abhängig sein. Jeder Bestandteil des Internet (Computer, Programm, Browser) muss gegen einen anderen austauschbar sein, ohne dass für den Nutzer ein erkennbarer Unterschied entsteht.

Nicht nur das sicht- und erlebbare Word Wide Web wird in Form von HTML 5 weiterentwickelt. Auch im Hintergrund sind größere Veränderungen nötig, um die gestiegenen Anforderungen an das Internet zu bedienen. Im TCP/IP-Netzwerk, das in den 1970ern im Parc entwickelt wurde und die Basis für die meisten Rechnernetzwerke bildet, benötigt jeder Teilnehmer eine eigene sogenannte IP-Adresse. Diese 32 bit lange Ziffernfolge besteht aus vier Zahlen (0 bis 255). Nur Geräte mit einer IP-Adresse dürfen im Internet Daten versenden und empfangen. Doch wegen der Kürze ist die Anzahl dieser Adressen auf etwa vier Milliarden begrenzt und somit auch die Anzahl der teilnehmenden Geräte am Internet. Die meisten technischen und juristischen Internetprobleme haben direkt und indirekt mit IP-Adressen zu tun; ein wesentliches Problem ist, dass die meisten Geräte keine feste IP-Adresse besitzen können. Daher soll der alte IPv4-Standard möglichst bald von IPv6 abgelöst werden, der die Anzahl der möglichen Adressen auf rund 340 Sextillionen erhöht. Doch dazu muss die gesamte Infrastruktur des Internet IPv6-tauglich sein. Da im Gegensatz zu HTML 5 die Vorteile nicht direkt sichtbar sind und da das Internet bislang halbwegs gut funktioniert, ist die Motivation, die gesamte Infrastruktur für viele Millionen Euro zu modernisieren, gering.

Die Quantität verändert die Qualität

Die oft zitierte Veränderung des Medienverhaltens durch das Internet beruht allerdings nicht auf einer neuen Qualität, sondern lediglich auf der Quantität. Es ist mithilfe des Computers und eines Webservers viel billiger, seine Gedanken anderen mitzuteilen, als früher. Entweder hätte man Broschüren drucken oder einen Verlag finden müssen. Mit einer eigenen Homepage wird sozusagen jeder zum Verleger – zu sehr niedrigen Kosten. Dadurch existieren mehr „Verlage“ und mehr Meinungen als in der Gutenberg-Ära, wo jede Äußerung gedruckt werden musste, um verteilbar zu sein.

Der gesunkene Aufwand führte zu einer größeren Vielfalt der Äußerungen und zu einer Erhöhung der Äußerungsmenge. Vergleicht man beispielsweise die Einträge in einem gedruckten Lexikon und in der Wikipedia, fällt auf, dass Wikipedia-Einträge oft um ein Vielfaches länger sind als Lexikoneinträge. Das allein sagt allerdings noch nichts über die Qualität der Einträge aus. Online-Texte brauchen sich nicht dem Kostendruck eines kalkulierten Seitenumfangs zu beugen. Die Erhöhung der Quantität führt aber zu einer Veränderung der Qualität, was sich als Emergenz-Phänomen beschreiben lässt.

| Internet | Gutenberg-Galaxis |

|---|---|

| Link | Verweis (z. B. Seitenzahl, Buchtitel) |

| Textlänge nur durch Speicherplatz begrenzt (billig) | Textlänge ist Kostenfaktor (bedrucktes Papier) |

| Online-Chat | Gespräch (im Angesicht, via Telefon) |

| Postkarte, Brief | |

| Datentransfer | Brief, Paket, Bote |

| Musik, Film | Schallplatte, CD, VHS-Kassette, DVD |

| Kommentarfunktion | Leserbrief |

| Online-Veröffentlichung (ein Sender – viele Empfänger) | Veröffentlichung in Druck oder Funk (ein Sender – viele Empfänger) |

| Suche („googeln“) | Recherche (Bibliothek, Kataloge) |

Webseiten bieten die gleichen Nutzungsmöglichkeiten wie alte Medien: Einer veröffentlicht, viele lesen. Nur die Anzahl der Veröffentlicher hat sich erhöht. Das „Web 2.0“ lässt jeden Empfänger zum Sender werden, indem er oder sie Texte kommentiert, Diskussionen in Foren initiiert oder Texte direkt bearbeitet. Für letzteres ist die Wikipedia das prototypische Beispiel, auch in Firmen-Intranetzen werden Dokumente mitunter nicht vorgegeben, sondern entstehen erst durch die Beteiligung vieler.

Die Wikipedia zeigt auch, wie Verweise auf andere Lexikoneinträge funktionieren. Statt einen Begriff nur anzugeben und den Nutzer dadurch aufzufordern, diesen selbst aufzusuchen, sind Begriffe direkt verlinkt. Statt zu blättern, genügt es, diesen Link anzuklicken – und schon gelangt man an das Verweisziel. Für jemanden, der gelegentlich surft, ist diese Beobachtung trivial. Dennoch ist ein Link nichts anderes als ein Verweis in einem Lexikon.

Links sind keine wahnsinnig spannende Angelegenheit. Sie weisen nur in eine Richtung, wie man zurückkommt, ist dem Ausgangslink egal. Sie verkürzen im Wesentlichen nur das manuelle Suchen des Nutzers, senken also die Hemmschwelle, einem angegebenen Verweis tatsächlich zu folgen. Links sind nicht intelligent; wurde das Ziel entfernt, führt der Link ins Leere. Links sind passiv, erst durch die jeweils neue aktive Nutzung (Anklicken) entsteht ihr Wert, der nur in einem unaufwändigen Erreichen des Ziels besteht.

Vannevar Bush hatte in seinem Aufsatz „How we may think“ bereits 1941 eine Memex genannte Maschine erdacht, die als gedanklicher Vorläufer des World Wide Web angesehen wird. Seine Maschine basierte nicht auf digitalen Daten, sondern auf Mikrofilmen, die vielfach miteinander verknüpft waren. Eines der Merkmale war, dass diese Verknüpfungen nicht nur passiv gesetzt waren. Jede Recherche ergab einen Link-Pfad, den sich die Memex merkte. Dadurch wurde das Verweisnetz dichter, häufig genutzte Links wurden stärker, neue Verbindungen ergänzten oder erweiterten das Netz. Die „Klugheit“ der Dokumente wuchs bereits durch die Nutzung, ohne dass neue Informationen hinzugefügt werden müssten.

Im Vergleich dazu ist das Internet dämlich. Es kennt nur Verweise, die Textautoren manuell setzen. Der Leser eines Textes kann diese nicht verändern oder ergänzen. Der Leser ist gezwungen, sich selbst zu merken, welche Seiten er besucht hat. Dabei hilft ihm die Browserhistorie, die allerdings nur wenige Einträge umfasst und die Beziehungen der Seiten nicht darstellt; sie weiß nur, welche Seiten der Nutzer in welcher Reihenfolge aufgerufen hat.

Das Internet hat die Welt verändert. Dies allerdings bislang nicht aus der Tatsache heraus, dass es etwas Neues ist, sondern nur dadurch, dass es Bestehendes neu miteinander verband oder Äquivalente für bestehende Lösungen integrierte. Im Wesentlichen wurden nur die Kosten- und Aufwandsschwellen gesenkt, sodass mehr Menschen daran partizipieren können. Durch die Fähigkeit, andere Dateien innerhalb einer HTML-Datei zu integrieren, wurde das Internet zu einem Medienkonglomerat.

Ein neues Medium

Das Bemerkenswerteste am Internet ist seine kulturelle Bedeutung. Diese ergibt sich daraus, dass Zugangs- und Nutzungshindernisse verschwinden und Schwellen sinken. Damit kann der Umgang anders erfolgen als bei bisherigen Medien, und die aktive Teilnahme ist leichter möglich. Das Internet beeindruckt weniger in seiner technischen Gestalt als vielmehr in der Wirkung auf die Menschen, auf den Umgang der Menschen miteinander, auf die Wirtschaftsbeziehungen der Menschen, auf den Alltag.

Versteht man unter „Gutenberg-Galaxis“ nicht nur das Bedrucken von Papier, sondern auch die Implikationen, leben wir quasi in der „Gutenberg-Galaxis 2.0“. Die Übersicht fasst einige Tendenzen zusammen und geht vom Idealfall aus, dabei vernachlässige ich audiovisuelle Medien wie Theater, Kino, Radio oder Fernsehen.

| Prä-Gutenberg (vor 1500) | Gutenberg-Ära (1500–2000) | Post-Gutenberg (ab 2000) | |

|---|---|---|---|

| Motivation | Auftraggeber (Mäzen) | individuell, Auftrag, Markt | individuell, Auftrag |

| Kreation | individuell | individuell (selten kollaborativ) | individuell und kollaborativ |

| Distribution | Einzelstück (Manuskript), orale Tradierung | Publikation, Verlagswesen | Web |

| Rezeption | Gruppe (Vortrag), individuell | individuell (lesen) | individuell („surfen“) |

| Kollaboration | nur von Angesicht zu Angesicht | Kompilate, Lektorat, schriftlicher Austausch | Kommentar, Diskussion, Bearbeitung |

| Recherche | individuelles Wissen | Kataloge, Bibliotheken | Direktsuche, „googeln“ |

| Feedback | individuell; Lob oder Tadel | individuell; Verkaufszahlen | direkt; Klickzahlen |

| Beispiele | Historie, „Parzival“, Minnesang | Ratgeber, Autobiografie, Roman | News-Site, Blog, Wikipedia |

Wir arbeiten auch im Web mit dem selben Werkzeug wie unsere Vorväter in der Antike: mit Schriftzeichen. Die mit der Gutenberg-Ära verbundene allgemeine Alphabetisierung trug dazu bei, dass der Gedankenaustausch und die Gedankenverbreitung auf Schrift basiert. Für die Entstehung neuer Gedanken und deren Verbreitung ist nicht nur der Buchdruck allein verantwortlich. Viele Gelehrte trugen Notizbücher mit sich und führten Sentenzenbücher (common-place books), was erst durch die preiswerte Verfügbarkeit von Papier und Schreibmaterial möglich wurde. Das sich weiter verbessernde Post-System erleichterte den Gedankenaustausch.

Die Entstehung neuer Gedanken setzt immer den Gedankenaustausch voraus: das Gespräch von Angesicht zu Angesicht, der Briefwechsel, der stille Dialog mit einem Lesetext, bei dem der Leser den verschriftlichten Aussagen folgt und eine eigene Meinung dazu ausbildet, die unbewusste Auseinandersetzung bei der Betrachtung eines Kunstwerkes, die versucht, verschiedene Aspekte zu ergründen, die Diskussion in einem Web-Forum. Nur wenn verschiedene Gedanken zusammenkommen, kann daraus etwas Neues entstehen oder entwickelt werden.

Somit begünstigte die Gutenberg-Ära als Nebeneffekt nicht nur die Verbreitung fertiger Gedanken, sondern auch die Entwicklung neuer. Es wurde zunehmend leichter, beim Dialog nicht auf die Präsenz des anderen angewiesen zu sein, sondern über Briefe Gedanken auszutauschen. Man musste sein Wissen nicht ständig in seinem Kopf parat haben, sondern konnte sich eine kleine Privatbibliothek mit erworbenen Büchern und selbst zusammengestellten Notizen aufbauen. Dieses Wissensmanagement wird durch die neuen technischen Möglichkeiten noch effektiver, wie man am steten Wachstum der Wikipedia und am Entstehen zahlreicher weiterer Wikis zu den ungewöhnlichsten Themen erkennt.

Somit leben wir möglicherweise nur in einer verlängerten oder verbesserten Gutenberg-Galaxis und lassen die Gutenberg-Ära hinter uns. Dabei ist die Namensgebung überdenkenswert, denn Gutenberg kann zwar als Erfinder des Buchdrucks gelten, aber nicht als Erfinder der Schriftzeichen. Ebenfalls ist zu berücksichtigen, dass „Alphabetisierung“ sich nur auf die Schreib- und Lesekundigkeit mittels Schriftzeichen bezieht. Im Mittelalter beispielsweise waren viele Bilder kodiert und stellten mehr dar als uns meist bewusst ist. Mithilfe bestimmter Insignen konnte jede dargestellte Frau in die Nähe der Heiligen Jungfrau Maria gerückt werden. Dies sollte weniger bedeuten, dass es sich um Maria handelt, als vielmehr, dass die dargestellt Person mariengleich tugendhaft war.

Um solche nicht-schriftlichen Zeichen oder Symbole zu erkennen, ist gewissermaßen eine „kulturelle Alphabetisierung“ nötig. Bilder enthielten über ihre Darstellung hinaus noch eine inhaltliche Komponente, Symbole hoben das Bild über die rein ästhetische Wirkung hinaus. Bei Schriftzeichen ist im Vergleich dazu die ästhetische Wirkung der inhaltlichen Bedeutung zumeist stark nachgeordnet.

Den symbolhaft aufgeladenen Bildern der Antike und des Mittelalters sind zahlreiche Bilder auf Webseiten strukturell ähnlich. Zu der inhaltlichen und ästhetischen Ebene gesellt sich eine funktionale. Denn ein Bild in einer Webseite ist meist mehr als nur ein Bild. Klickt man es an – was bei vielen möglich ist –, landet man an einem Verweisziel oder erhält eine große Ansicht des Bildes oder ruft das nächste Bild in einer Bildserie auf. Wird Text in eine Grafik integriert, um einen Button darzustellen, verschmelzen Schriftzeichenwelt und Bildwelt zu einem neuen Element, beispielsweise einem „Home“-Button. Die Gestaltung oder Platzierung gibt oft Hinweise auf die funktionelle Komponente.

Auch der Text erhält im World Wide Web eine zusätzliche Ebene bzw. diese wird deutlich stärker betont als in Drucktexten: die hierarchische Struktur. Nicht mehr nur der Textinhalt ist von Bedeutung, sondern auch die hierarchische Position, die Verknüpfung mit anderen Texten, der umgebende Kontext, die Integration von Web-Funktionen. Dabei sind zwar alle Texte potenziell gleichberechtigt, aber jeder kann eine eigene komplexe Struktur oder Hierarchie aufweisen. Alte Kulturtechniken wie zeichnen, malen oder schreiben verlieren durch diese neuen Verwendungsmöglichkeiten nicht, sondern werden quasi mehrdimensionaler.

Damit lässt sich eine Evolution der Symbol- bzw. Zeichenverwendung skizzieren: Am Anfang standen kodierte Bilder, Symbole fügten zusätzliche Bedeutung hinzu, die schematische Abbildung eines Tieres stand beispielsweise für eine Tiergattung. Das Alphabet löst die Wortbedeutung von seiner Erscheinung, indem die Schriftzeichen die Sprachlaute abbilden; damit ist jeder aussprechbare Gedanke auch schreibbar. Das Web unterstreicht Hierarchien und Strukturen, es verknüpft Texte oder Textbestandteile miteinander und mit anderen Medien, ermöglicht deren direkte Veränderung und geht über die reine Präsentation hinaus, indem es mit „Web 2.0“-Möglichkeiten die einst passiven bzw. nur interpretierenden Rezipienten zum Dialog auffordert.

Die funktionale Erweiterung der bisherigen Zeichenwelten ist jedoch durch das bestehende Link-System eingeschränkt. Beispielsweise kann nicht auf eine beliebige Stelle in einem Text verwiesen werden, sondern nur auf vom Textautor gesetzte Sprungmarken, mindestens aber auf den Text als Ganzes. Auf Bilder ist nur als Einzelelement ohne Kontext verweisbar – oder auf den Gesamtkontext. Der Schöpfer oder Autor behält mit den Sprungmarken („Anker“) stets die Kontrolle, wohin verwiesen werden kann. Das einzige, was er nicht verhindern – und auch nicht verbieten – kann, ist das Verlinken auf die von ihm geschaffenen und online veröffentlichten Werke mindestens als Ganzes.

Regeln des Miteinander

Seit den Kindertagen des Internet (also noch vor dem World Wide Web) gibt die Netiquette sinnvolle Empfehlungen zum Umgang der Nutzer miteinander. Wer sich nicht an diese hält, macht sich nicht nur unbeliebt, sondern verhindert mitunter sogar, dass die potenziellen Empfänger seine Mitteilungen überhaupt erhalten.

Über jeden der fünf Aspekte, die in der Netiquette angesprochen werden, ließen sich umfangreiche Pamphlete verfassen: Zwischenmenschliches, technische Aspekte, Lesbarkeit, Sicherheit, Rechtliches. Der Tonfall und der Inhalt seiner Äußerungen sollten dem Ziel und der Situation angemessen sein. Dateien sollen in einem Format angeboten werden, das möglichst viele nutzen können. Im Alltag wechsele ich ja auch nicht plötzlich zu einer Sprache, von der ich nicht weiß, ob der andere sie versteht. Ein gepflegter Ausdruck sowie die Kenntnis von Rechtschreibung, Grammatik und Zeichensetzung sorgen für die Lesbarkeit. Wer nur in Großbuchstaben schreibt, gilt als ungeliebter Schreihals. Nachrichten enthalten nur das Wichtigste; sind Informationen nur für bestimmte Empfänger gedacht, dann muss sichergestellt werden, dass auch nur diese sie erhalten. Jeder Nutzer sollte ein Grundverständnis der Rechtssituation haben. So wie das Töten im Alltag rechtlich sanktioniert ist, so werden im Internet Beleidigungen, Urheberrechtsverletzungen oder Sabotage, Belästigung (Viren, Spam-Mails) bestraft.

Ein praktischer Punkt der Netiquette betrifft die Formate von Daten, die man anderen übermittelt. So ist es in der Praxis unhöflich, .doc- oder .docx-Dateien anzubieten, da das Word-Format Microsoft gehört und nicht vorausgesetzt werden kann, dass jeder Nutzer das Word-Programm installiert hat, für Linux ist es beispielsweise nicht verfügbar. .rtf-Dateien dagegen kann jeder Computer ordentlich verarbeiten. Wenn man also die technische Ausstattung des Empfängers (oder Surfers) nicht genau kennt, muss man Dateiformate wählen, die jeder unaufwändig benutzen kann. So ist bei Internetseiten (also HTML-Dateien) zu berücksichtigen, dass nicht jeder Nutzer den aktuellsten Browser installiert hat. Daher ist es sinnvoll, die letzte große Version als kleinsten gemeinsamen Nenner zu verwenden und neue HTML-Funktionen erst dann ohne Alternative anzubieten, wenn alle fünf großen Browserhersteller diese auch unterstützen. Aus dem selben Grund werden eMails sinnvollerweise nur als reine Text-Nachricht versandt, denn dies ist die einzige Gewähr, dass der Empfänger den Inhalt auf jeden Fall wahrnehmen kann.

Die wichtigste Regel der „Netiquette“ lautet: Vergiss niemals, dass auf der anderen Seite ein Mensch sitzt! Wie du möchte dieser Mensch mit Respekt behandelt und nicht belästigt oder beleidigt werden. Er oder sie möchte kein spezielles Zusatzprogramm installieren müssen, um Internetangebote zu nutzen oder Inhalte angezeigt zu bekommen.

Überblick über „Der Apple-Faktor, Band I“:

1. Einleitung

2. Die Anfänge

3. Von der Taste zum Touch

4. Von der Anweisung zum Klick

5. Virtueller Schreibtisch

6. Vom Buchstaben zur Transparenz

7. Vom Einzelplatz zum Netz

8. Von der Philosophie zum Kompromiss

9. Die wunderbare Welt der Software

10. Zum Ende: Versuch eines Vergleichs zwischen Mac OS X und Windows Sieben

Epilog: Eine neue Zeit

ein Kind der 70er • studierter Anglist/Amerikanist und Mediävist (M.A.) • wohnhaft in Berlin • Betreiber dieses Blogs zanjero.de • mehr über Alexanders Schaffen: www.axin.de ||

ein Kind der 70er • studierter Anglist/Amerikanist und Mediävist (M.A.) • wohnhaft in Berlin • Betreiber dieses Blogs zanjero.de • mehr über Alexanders Schaffen: www.axin.de ||

Pingback: Der Apple-Faktor: Einleitung | zanjero.de